產品概覽

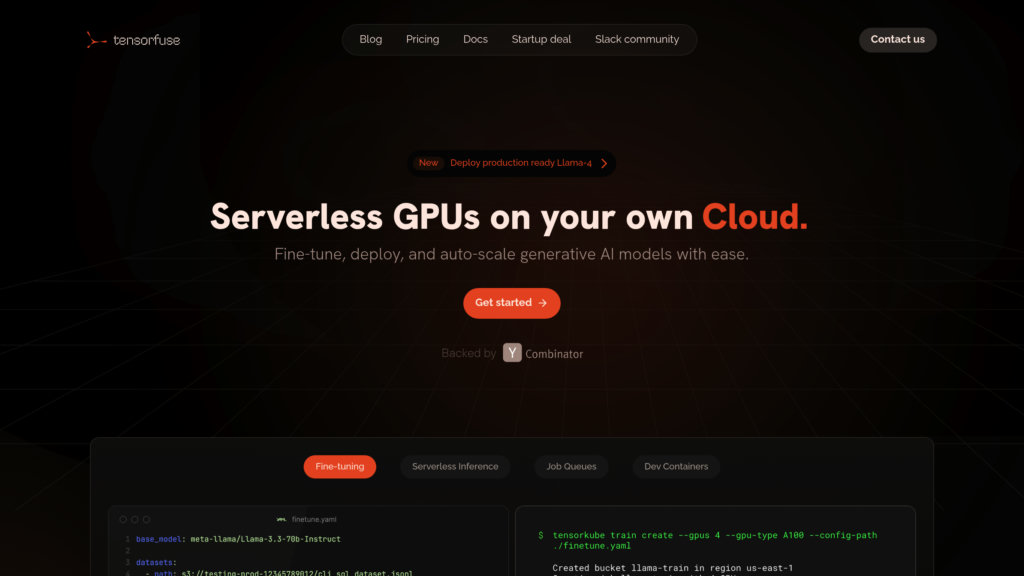

Tensorfuse 是什麼?

Tensorfuse 是一個尖端平台,專為簡化在您自有雲端基礎設施上運行生成式 AI 模型而設計。它可自動管理 Kubernetes 叢集,提供 serverless GPU 運算,閒置時資源自動降至零,需求提升時又能快速擴充。Tensorfuse 支援多元硬體(如 A10G、A100、H100 GPU、TPU、Trainium/Inferentia 晶片、FPGA),讓模型部署更彈性高效。平台同時提供 OpenAI 相容 API、serverless 訓練任務與內建 LoRA、QLoRA 微調工具,徹底簡化複雜的基礎設施管理,加速 AI 開發並降低雲端 GPU 成本。

主要功能

Serverless GPU 管理

自動化調度 GPU 資源,從零開始動態擴展,無需人工干預,即可同時處理多重工作負載。

多硬體支援

可於多種硬體上執行 AI 工作,包括 NVIDIA GPU、TPU、Trainium/Inferentia 晶片與 FPGA。

OpenAI 相容 API

讓您的 AI 模型透過與 OpenAI 標準相容的 API 對外整合,輕鬆接軌應用。

內建模型微調

支援 LoRA、QLoRA 與增強式學習等進階微調技術,開箱即用。

自訂 Docker 與網路架構

最佳化 Docker 實作,縮短冷啟動時間,並採用自訂的 Istio 網路層,支援多節點 GPU 推論與訓練。

開發者生產力工具

GPU devcontainer 支援熱重載,讓您無需繁瑣設定,即可直接在 GPU 上快速實驗。

使用案例

- AI 模型部署 : 可於私人雲端快速部署自訂 AI 模型,並透過 serverless GPU 自動擴展。

- 生成式 AI 應用 : 高效執行 Llama3、Qwen、Stable Diffusion 等生成式 AI 模型之推論與批次任務。

- 模型微調與訓練 : 利用先進技術,免管理環境,即可 serverless 進行大型模型訓練與微調。

- 雲端 GPU 成本優化 : 透過智慧自動擴展與高效資源管理,雲端 GPU 成本可降低高達 30%。

- DevOps 自動化 : 整合 GitHub Actions,自動化部署流程,簡化基礎設施管理。

常見問題

Tensorfuse 的替代方案

Pipekit

一個用於在 Kubernetes 上管理和優化 Argo Workflows 的可擴展控制平面,實現高效的資料和 CI 流水線操作。

Modelbit

基礎設施即程式碼平台,用於無縫部署、擴展和管理生產環境中的機器學習模型。

Movestax

一站式 serverless 雲端平台,專為現代開發者簡化應用部署、serverless 資料庫、工作流程自動化與基礎架構管理而設計。

Brainboard

一個用於視覺化設計、生成和管理雲端基礎設施的協作平台,具有自動Terraform程式碼生成功能。

dstack

專為AI工作負載客製化的開源容器協調平台,實現跨雲端和本地環境的無縫GPU資源管理。

UbiOps

一個靈活的平台,用於在雲端、本地和混合環境中部署、管理和編排AI和ML模型。

Codesphere

以開發者為中心的雲平台,透過最少的配置實現無縫部署、自動擴展和複雜應用管理。

CTO.ai

一個以開發者為中心的平臺,提供工作流程自動化、CI/CD管道和雲基礎設施編排,以簡化軟體交付。

Tensorfuse 網站分析

🇺🇸 US: 51.47%

🇮🇳 IN: 48.52%

Others: 0%