LM Arena (Chatbot Arena)

开源、社区驱动的大语言模型(LLM)实时基准测试与评测平台,采用众包成对对比和Elo评分体系。

产品概览

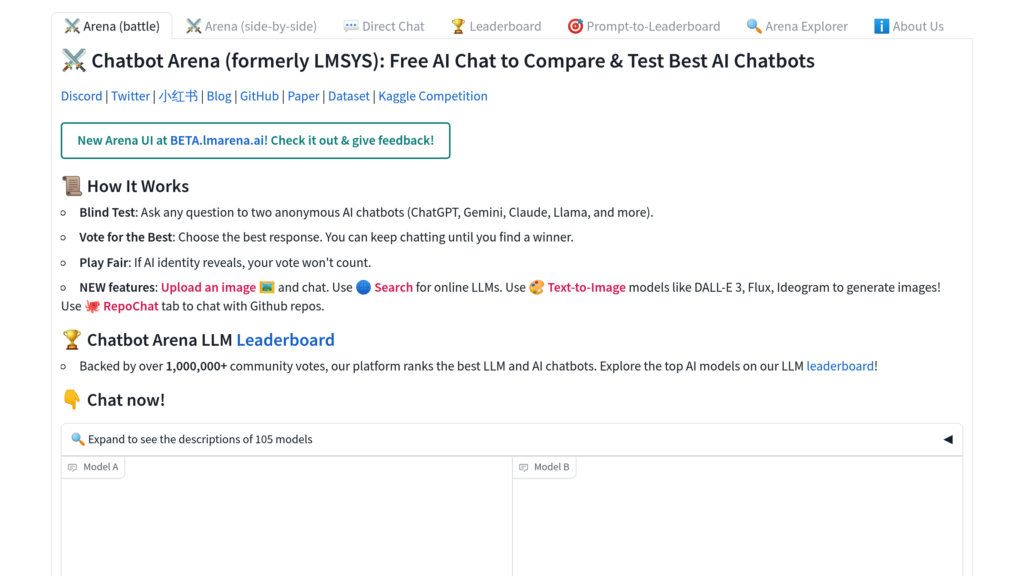

什么是LM Arena (Chatbot Arena)?

LM Arena(又称Chatbot Arena)是由LMSYS与UC Berkeley SkyLab联合开发的开源平台,旨在通过实时、透明、社区驱动的评测推动大语言模型的发展与理解。用户可匿名与多款LLM进行对比互动,通过投票使用Elo评分系统对模型进行排名。平台支持多种公开发布的模型,包括开源权重和商业API,并根据真实用户反馈持续更新排行榜。LM Arena强调透明、开放科学与协作,所有数据集、评测工具和基础设施均在GitHub上公开。

主要功能

众包式成对模型对比

用户以匿名、随机的方式参与两款大模型(LLM)的对战,通过投票选出更优回答,从而生成可靠的对比数据。

基于Elo评分的模型排名体系

采用广泛认可的Elo评分系统,为大模型性能提供动态、统计可靠的排名。

开源基础设施

平台所有组件,包括前端、后端、评测流程和排名算法,均为开源并公开可用。

实时与持续评测

通过实时收集用户输入和投票,确保基准测试能够反映当前模型能力与真实应用场景。

支持公开发布模型

涵盖开源权重、可通过API访问或以服务形式提供的模型,确保透明性与可复现性。

社区参与与透明化

鼓励广泛参与,公开用户偏好数据和提示词,促进协作式AI研究。

使用场景

- 大模型性能基准测试 : 研究人员和开发者可在真实场景下评估和对比各类大语言模型的效果。

- 部署模型选择 : 机构可通过查看社区驱动的实时排名,甄选最适合自身应用的大模型。

- 开放科学与研究 : 学者与AI从业者可访问共享数据集和工具,进行可复现研究并推动模型优化。

- 基于社区反馈的模型优化 : 模型提供方可收集匿名用户反馈和投票数据,在正式发布前优化自身AI系统。

常见问题

LM Arena (Chatbot Arena)的替代方案

RunPod

专为AI工作负载优化的云计算平台,提供可扩展GPU资源,支持AI模型的训练、微调与部署。

Geekbench

一款跨平台的基准测试工具,用于测量各类设备和操作系统下的CPU与GPU性能。

MiroMind

一个利用开源模型进行深度数据分析、网络搜索和代码生成的研究助手。

Sakana AI

总部位于东京的 AI 研究公司,开创自然启发式基础模型与全自动 AI 科研新纪元。

Ballpark

一站式用户调研平台,支持多样测试方式和多媒体洞察,轻松收集产品创意、文案、设计及原型的高质量反馈。

Userbrain

无主持远程用户测试平台,通过全球测试员池和自动化分析工具简化UX研究。

MindSpore

面向全场景的开源深度学习框架,易于开发、高效执行,并实现云、边、端统一部署。

LAION

非营利组织提供海量开放数据集、模型和工具,支持可访问和可持续的机器学习研究。

LM Arena (Chatbot Arena)网站分析

🇨🇳 CN: 57.85%

🇷🇺 RU: 3.5%

🇮🇳 IN: 2.72%

🇸🇳 SN: 2.29%

🇺🇸 US: 1.66%

Others: 31.97%