LM Arena (Chatbot Arena)

Plataforma de código abierto y dirigida por la comunidad para el benchmarking en vivo y la evaluación de modelos de lenguaje grande (LLMs) mediante comparaciones por pares y puntuaciones Elo.

Descripción del Producto

¿Qué es LM Arena (Chatbot Arena)?

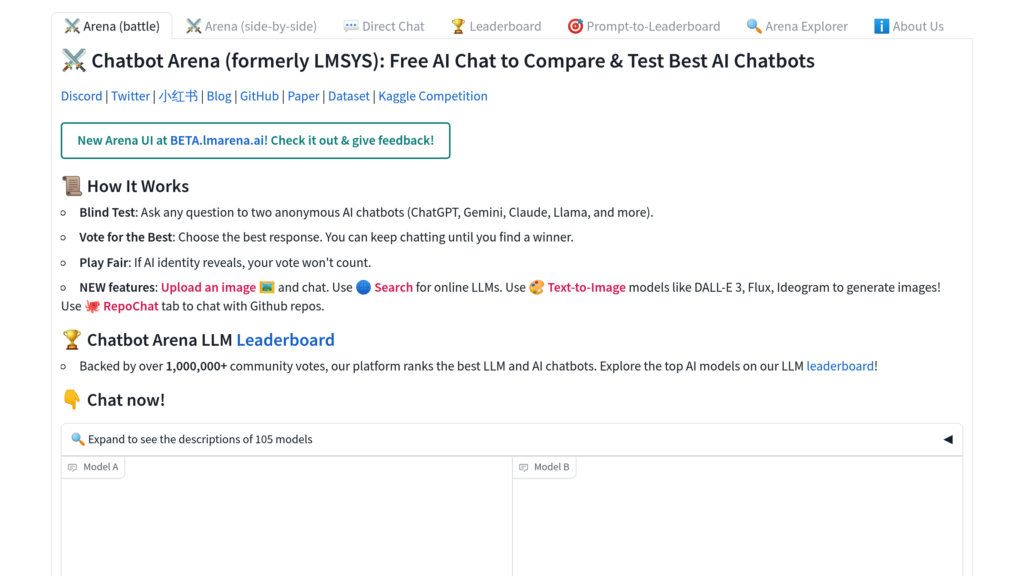

LM Arena, también conocido como Chatbot Arena, es una plataforma de código abierto desarrollada por LMSYS y UC Berkeley SkyLab para avanzar en el desarrollo y la comprensión de los modelos de lenguaje grande mediante evaluaciones en vivo, transparentes y dirigidas por la comunidad. Permite a los usuarios interactuar y comparar múltiples LLMs en batallas anónimas, recopilando votos para clasificar los modelos usando el sistema Elo. La plataforma soporta una amplia gama de modelos publicados, tanto open-weight como APIs comerciales, y actualiza continuamente su ranking basado en la retroalimentación real de los usuarios. LM Arena enfatiza la transparencia, la ciencia abierta y la colaboración compartiendo datasets, herramientas de evaluación e infraestructura abiertamente en GitHub.

Características Principales

Comparación por pares de modelos mediante crowdsourcing

Los usuarios participan en batallas anónimas y aleatorias entre dos LLMs, votando por la mejor respuesta para generar datos comparativos fiables.

Sistema de clasificación Elo para ranking de modelos

Adopta el reconocido sistema de puntuación Elo para proporcionar clasificaciones dinámicas y estadísticamente sólidas del rendimiento de los LLM.

Infraestructura de código abierto

Todos los componentes de la plataforma, incluyendo frontend, backend, pipelines de evaluación y algoritmos de ranking, son de código abierto y están disponibles públicamente.

Evaluación continua y en tiempo real

La recopilación en tiempo real de prompts y votos de los usuarios garantiza una evaluación actualizada que refleja las capacidades actuales de los modelos y casos de uso reales.

Soporte para modelos publicados públicamente

Incluye modelos open-weight, accesibles públicamente mediante APIs o disponibles como servicios, asegurando transparencia y reproducibilidad.

Participación comunitaria y transparencia

Fomenta la participación amplia y comparte abiertamente los datos de preferencias y prompts de los usuarios para impulsar la investigación colaborativa en IA.

Casos de Uso

- Benchmarking del rendimiento de LLM : Investigadores y desarrolladores pueden evaluar y comparar la efectividad de varios modelos de lenguaje grande en condiciones reales.

- Selección de modelos para despliegue : Las organizaciones pueden identificar los LLM con mejor rendimiento para sus aplicaciones específicas revisando los rankings impulsados por la comunidad.

- Ciencia abierta e investigación : Académicos y profesionales de IA pueden acceder a conjuntos de datos y herramientas compartidas para realizar investigaciones reproducibles y mejorar el desarrollo de modelos.

- Retroalimentación comunitaria para la mejora de modelos : Los proveedores de modelos pueden recopilar feedback anónimo de los usuarios y datos de votación para perfeccionar y mejorar sus sistemas de IA antes de los lanzamientos oficiales.

Preguntas Frecuentes

Alternativas a LM Arena (Chatbot Arena)

RunPod

Una plataforma de computación en la nube optimizada para cargas de trabajo de IA, que ofrece recursos GPU escalables para entrenar, ajustar y desplegar modelos de IA.

Geekbench

Una herramienta de evaluación multiplataforma que mide el rendimiento de CPU y GPU en varios dispositivos y sistemas operativos.

Ballpark

Una plataforma de investigación de usuarios que simplifica la obtención de feedback de alta calidad sobre ideas de producto, mensajes de marketing, diseños y prototipos con métodos de prueba versátiles y análisis multimedia enriquecidos.

Sakana AI

Empresa de investigación en IA con sede en Tokio, pionera en modelos fundacionales inspirados en la naturaleza y en el descubrimiento científico automatizado por IA.

Userbrain

Plataforma de testing de usuario remoto no moderado que agiliza la investigación UX a través de un pool global de testers y herramientas de análisis automatizadas.

MindSpore

Un framework de deep learning de código abierto para todos los escenarios, diseñado para un desarrollo sencillo, ejecución eficiente y despliegue unificado en entornos de nube, borde y dispositivos.

UXArmy

Plataforma integral de investigación de usuarios remota que ofrece insights de usabilidad rápidos y accionables a través de grabaciones de video y análisis avanzados.

无问芯穹

Plataforma de computación heterogénea de nivel empresarial que permite el despliegue eficiente de modelos grandes en diversas arquitecturas de chips.

Analítica del Sitio Web de LM Arena (Chatbot Arena)

🇷🇺 RU: 13.21%

🇮🇳 IN: 9.98%

🇺🇸 US: 9%

🇨🇳 CN: 6.32%

🇰🇷 KR: 3.6%

Others: 57.89%